จัดการข้อมูลขนาดใหญ่ด้วย Apache Hadoop สำหรับองค์กร

ปัจจุบันนี้ การจัดการข้อมูลขนาดใหญ่หรือที่เรียกกันว่า Big Data นั้น อาจไม่สามารถทำได้โดย SQL Database อีกต่อไป เนื่องจาก SQL Database ในปัจจุบันนี้ถูกออกแบบมาเป็นเวลานานแล้ว ในขณะที่ความต้องการการใช้ข้อมูลกลับมีเพิ่มขึ้นเรื่อยๆ จน SQL Database แบบเดิมๆ ไม่อาจรับได้ไหวอีก แนวคิดในการทำ Distributed Computing จึงเกิดขึ้นมา และ Apache Hadoop เองก็มีบทบาทในด้านนี้เป็นอย่างมาก

Apache Hadoop คืออะไร?

![]()

Apache Hadoop คือโครงการ Opensource Software สำหรับการสร้างระบบ Distributed Computing ที่มีความเสถียรสูง และสามารถเพิ่มขยายได้อย่างมหาศาล โดยตัวอย่างของผู้ที่ใช้งาน Apache Hadoop นั้นมีดังนี้

Facebook นั้นมี Apache Hadoop Cluster อยู่ด้วยกัน 2 ชุด ชุดแรกประกอบจาก Server จำนวน 1,100 เครื่อง, CPU 8,800 Cores และพื้นที่ 12PB (12,000TB) และชุดที่สองประกอบจาก Server จำนวน 300 เครื่อง, CPU 2,400 Cores และพื้นที่ 3PB (3,000TB)

Yahoo!

Yahoo! นั้นใช้ Server มากกว่า 40,000 เครื่อง, CPU มากกว่า 100,000 ชุดสำหรับรองรับระบบ Ads และ Web Search

นอกจากนี้ยังมีผู้ให้บริการรายใหญ่ๆ มากมายอย่าง Twitter, ImageShack, Adobe, AOL และอื่นๆ อีกมากมายที่ใช้ Apache Hadoop ในการจัดเก็บข้อมูลแทนฐานข้อมูลแบบ SQL รวมถึง Microsoft เองก็มีแผนที่จะให้ MS SQL สามารถทำงานเชื่อมต่อกับ Apache Hadoop ได้เช่นกัน อีกทั้งผู้ผลิตรายใหญ่ๆ อย่าง IBM และ Supermicro เองก็ให้การสนับสนุน Apache Hadoop กันเป็นอย่างมากอีกด้วย

ส่วนในวงการการศึกษาและทางภาคธุรกิจเอง Apache Hadoop ถือเป็นทางเลือกที่ดีในงานหลายๆ ประเภท ไม่ว่าจะเป็นงานประมวลผลประสิทธิภาพสูง (High Performance Computing), Scientific Computing, Image Processing, Information Retrieval, Machine Learning, Social Network Analysis, Data Mining, Business Intelligence (BI), Network Security, Sensor Data Storage, Biomedical, Statistic, Machine Translation, Language Modeling, Bioinformatic, Email Analysis และอื่นๆ อีกมากมาย และแนวโน้มการเติบโตของ Apache Hadoop ก็จะยังคงมีต่อไปเรื่อยๆ อีกด้วย

Hadoop: An Industry Perspective

การนำ Apache Hadoop ไปใช้

เนื่องจาก Apache Hadoop นั้นเป็น Opensource ให้สามารถใช้งานกันได้ฟรีๆ ดังนั้นผู้ที่สนใจจึงสามารถเข้าไปศึกษาและ Download Software ออกมาได้จากที่ Web Site ของ Apache Hadoop โดยตรง หรือสำหรับคนที่ชอบของสำเร็จรูปมากกว่า ก็สามารถ Download Distribution จาก Cloudera ได้เช่นกันครับ

Hardware สำหรับใช้งาน Apache Hadoop

เนื่องจาก Apache Hadoop นั้นเป็น Opensource ที่สามารถทำงานร่วมกันได้กับทั้ง Linux และ Microsoft Windows โดยเรียกใช้งาน Java เป็นหลัก ดังนั้น Apache Hadoop จึงสามารถทำงานบน Hardware ได้หลากหลาย โดยต้องทำการเลือก Spec สำหรับ Hardware ที่เหมาะสมสำหรับแต่ละหน้าที่ใน Cluster ของ Apache Hadoop ให้ดี

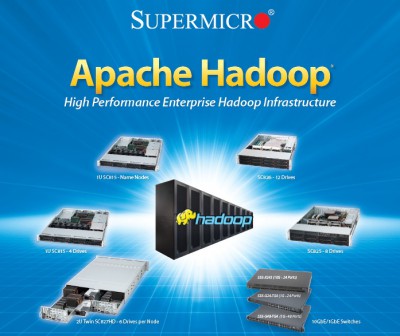

Apache Hadoop Server จาก Supermicro

ที่อเมริกา Supermicro เป็น Server ที่ได้รับความนิยมอย่างสูงสำหรับทำ Apache Hadoop มาก เนื่องจากมีความหลากหลายของ Hardware ที่สามารถปรับแต่งและเลือกใช้ให้เหมาะสมกับแต่ละหน้าที่ใน Hadoop และแต่ละ Project ที่แตกต่างกันได้ ทาง Supermicro จึงได้จัดชุดของ Hardware ที่เหมาะสำหรับการทำ Apache Hadoop มาดังนี้

- Apache Hadoop Name Node – เป็น Server ขนาด 1U สำหรับทำหน้าที่เป็น Apache Hadoop Name Node ติดตั้ง CPU Intel E5600 1 ชุด, หน่วยความจำ 48GB และ Hard Drive แบบ 147GB SAS 15k 2 ชุด

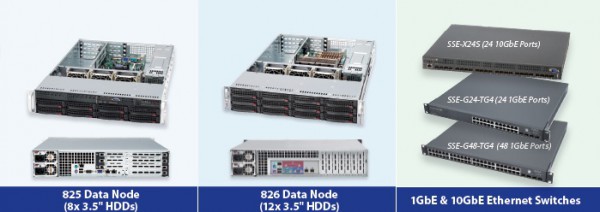

- Apache Hadoop Data Node 1U – เป็น Server ขนาด 1U สำหรับทำหน้าที่เป็น Apache Hadoop Data Node ติดตั้ง CPU Intel E5600 1 ชุด, หน่วยความจำ 24GB และ Hard Drive แบบ 2TB SATA จำนวน 4 ชุด รวมพื้นที่ 8TB ต่อ 1U เหมาะสำหรับระบบที่ต้องการลงทุนเริ่มต้นทีละเล็กน้อย

- Apache Hadoop Data Node 2U – เป็น Server ขนาด 2U สำหรับทำหน้าที่เป็น Apache Hadoop Data Node ติดตั้ง CPU Intel E5600 1 ชุด, หน่วยความจำ 24GB และ Hard Drive แบบ 2TB SATA จำนวน 12 ชุด รวมพื้นที่ 24TB ต่อ 2U เหมาะสำหรับระบบที่ต้องการใช้พื้นที่ขนาดใหญ่

- Apache Hadoop Twin Data Node 2U – เป็น Twin Server ขนาด 2U สำหรับทำหน้าที่เป็น Apache Hadoop Data Node มี Server 2 ชุดแบบ Hot Swap โดยแต่ละชุดติดตั้ง CPU Intel E5600 1 ชุด, หน่วยความจำ 24GB และ Hard Drive แบบ 2TB SATA จำนวน 12 ชุด รวมพื้นที่ 24TB ต่อ 2U เหมาะสำหรับระบบที่ต้องการใช้พื้นที่ขนาดใหญ่ และต้องการหน่วยประมวลผลจำนวนมาก

- 1GbE / 10GbE Ethernet Switches – สำหรับเชื่อมต่อระบบ Cluster ทั้งหมดด้วยความเร็ว 1GbE หรือ 10GbE ตามแต่ความต้องการของแต่ละระบบ

- IPMI Server Management – เป็นระบบสำหรับบริหารจัดการ Server จากระยะไกล โดยสามารถทำ Remote KVM-over-LAN และ Virtual Media-over-LAN เพื่อให้สามารถบริหารจัดการได้เสมือนทำงานอยู่ที่หน้าเครื่อง Server แต่ละเครื่องได้ผ่านทาง LAN โดยไม่ต้องมี Hardware เพิ่มเติม

โดยสำหรับผู้ที่ต้องการโซลูชันสำเร็จรูปเป็นพื้นฐานในการวางระบบครั้งแรก ทาง Supermicro ได้จัดชุด Hardware 2 ชุดหลักๆ ด้วยกันดังนี้

14U Hadoop Supermicro Rack

ตู้ Rack ขนาด 14U ซึ่งติดตั้ง Apache Hadoop Name Node 2 ชุด, Apache Hadoop Data Node 8 ชุด รวมพื้นที่ 48TB พร้อม Ethernet Switch และ Power Distribution Unit

42U Hadoop Supermicro Rack

ตู้ Rack ขนาด 42U ซึ่งติดตั้ง Apache Hadoop Name Node 2 ชุด, Apache Hadoop Data Node 10 ชุด รวมพื้นที่ 120TB พร้อม Ethernet Switch และ Power Distribution Unit

สำหรับรายละเอียด คุณสามารถ Download Datasheet จาก Supermicro ได้เลยนะครับ

สรุป

ในอนาคต Apache Hadoop และ Big Data Solution จะกลายเป็นสิ่งที่เข้ามามีบทบาทในระดับ Enterprise มากขึ้นเรื่อยๆ โดยค่าใช้จ่ายของ Hardware โดยรวมจะประหยัดกว่าระบบจัดเก็บข้อมูลแบบในปัจจุบัน เนื่องจากการนำ Server มาใช้งานในลักษณะ Cloud ทำให้สามารถตัดค่าใช้จ่ายของระบบจัดเก็บข้อมูลแบบ SAN Storage หรือ NAS Storage ได้ โดยมีความสามารถในการเก็บรักษาข้อมูลในระดับที่สูงขึ้นอีกด้วย

ดังนั้นการเลือกใช้ Hardware ให้เหมาะสมในระบบ Cloud จึงกลายเป็นสิ่งสำคัญตามมา ในขณะที่ผู้ดูแลระบบเองก็ควรจะต้องเริ่มศึกษาเทคโนโลยีใหม่ๆ เพิ่มเติมนอกเหนือจาก SQL Database แบบเดิมๆ ด้วยเช่นกัน

จบท้ายด้วยของฝากเล็กๆ น้อยๆ ครับ เป็น Gartner Report – Hadoop and MapReduce: Big Data Analytics ครับ ลองเข้าไปโหลดกันได้เลยนะครับ

———-

บทความโดย Throughwave Thailand

ท่านสามารถติดตามข่าวสารเพิ่มเติมได้ที่ https://www.throughwave.co.th